Deep Fake (for good) – Risiken und Potenziale für Unternehmen

03.05.2022 – Ein Beitrag von Carla Nieswandt, Paul Zimmermann und Max Bruhn

Als Teil unserer Recherche zu den technischen Hintergründen und den potenziellen Anwendungen der Deep Fake Technologie interviewte unser Team Samuel Nzekwe der FreeTech Academy von Axel Springer für Journalismus und Technologie. Samuel Nzekwe ist Software Entwickler der FreeTech Academy und war Teil des Projektteams für den Deepfake Report den wir stark weiterempfehlen. Wir bedanken uns beim gesamten FreeTech Team für die positive Zusammenarbeit.

Anwendungsbeispiele, Risiken und Potenziale für Unternehmen

Am 16.03.2022, rund drei Wochen nach dem Beginn des russischen Überfalls auf die Ukraine, erscheint auf der Website des ukrainischen Nachrichtensenders U24 ein Video des ukrainischen Präsidenten Wolodymyr Selenskyj, welches sich rasant im Netz verbreitet. Der speziell von westlichen Medien vorher vielfach für sein Durchhaltevermögen und Mut gefeierte Selenskyj verkündet darin plötzlich die Kapitulation seines Landes und fordert seine Soldaten auf, ihre Waffen niederzulegen und zu ihren Familien zurückzukehren.

Das Video ist von geringer Qualität, ein typisches Merkmal von Videoaufnahmen direkt aus einem umkämpften Kriegsgebiet, möchte man meinen. Doch auf den zweiten Blick fallen Unstimmigkeiten ins Auge: asymmetrische Kopf- und Mundbewegungen von Selenskyj wirken ebenso unnatürlich wie ein scheinbar in die Länge gezogener Hals und eine besonders statische Körperhaltung. Nach kurzer Zeit herrscht im Netz Übereinstimmung: Selenskyjs Kapitulation wurde gefälscht.

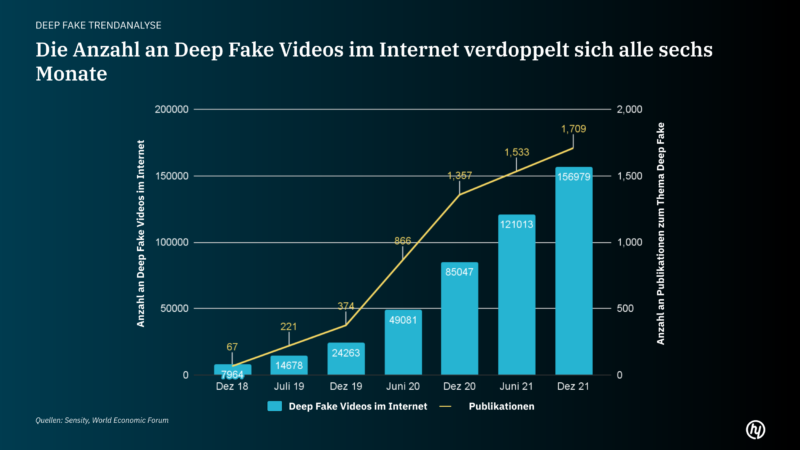

Das Selenskyj Video ist ein sogenannter Deep Fake, bei dem Medieninhalte durch die Anwendung von künstlicher Intelligenz erstellt werden. Die schnelle Identifikation als Fälschung (u.a. äußern sich Meta Sicherheitschef Nathaniel Gleicher und Selenskyj selbst zur Klarstellung) verhindert glücklicherweise schwerwiegende negative Folgen. Und trotzdem verdeutlicht der Einsatz von Deep Fakes als moderne Propagandawaffe den stetigen Zwiespalt bei der Weiterentwicklung von Technologien: neue Möglichkeiten der Wertschöpfung gehen zumeist einher mit ebenso dramatischen neuen Risiken durch kriminelle Nutzung. Die Auswirkungen des technologischen Fortschritts werden durch den Anwender definiert.

Als Unternehmensberatung spezialisiert auf digitale Transformation, beschäftigen wir uns bei hy fortlaufend mit neuen Technologien und ordnen diese in den wirtschaftlichen Kontext ein. Was verbirgt sich hinter Deep Fakes, die durch den Einsatz im Ukrainekonflikt neue Aufmerksamkeit generiert haben? Wie akut ist das Risiko durch Medienmanipulation auch in der Unternehmenswelt und wie kann man sich schützen? Und wie lässt sich Deep Fake Technologie, welche sich fortlaufend im dynamischen Fortschritt befindet, in Zukunft vielleicht sogar wertschöpfend im eigenen Unternehmen einsetzen?

Was ist ein Deep Fake?

Künstliche und autonom erstellte Medieninhalte, die wir als Deep Fakes bezeichnen, werden durch Einsatz von sogenannten Deep Learning Algorithmen („Deep“) mit dem Ziel einer realistischen Fälschung (“Fake”) generiert. Als Sub-Bereich des maschinellen Lernens, also des gezielten Trainierens von Algorithmen zur Identifikation von Mustern und Korrelationen in großen Datensätzen, sind Deep Learning Algorithmen für viele der weitreichenden Fortschritte im Bereich künstlicher Intelligenz der letzten Jahre verantwortlich.

Während die Einsatzmöglichkeiten zwischen Spracherkennung und -verständnis, selbstfahrenden Autos, und eben künstlicher Medienerstellung stark variieren können, basieren Deep Learning Algorithmen stets auf der Anwendung von sogenannten neuronalen Netzen, Algorithmus Strukturen, die dem menschlichen Gehirn nachempfunden sind. Im Bereich Deep Fakes werden Voice Deep Fakes, Body Puppetry und Face Swapping als verschiedene Arten der Manipulation unterschieden, die oftmals in Kombination genutzt werden, um die menschlichen Sinne bestmöglich zu täuschen.

Voice Deep Fakes entstehen bei der Nachahmung von Audiosequenzen. Vom Algorithmus antrainierte Stimmmerkmale können auf einen neuen Text projiziert werden und so eine Audioaufnahme von einer Stimme erstellen, die nie den verwendeten Text in der Realität ausgesprochen hat. Bei Body Puppetry wird mit Hilfe des Algorithmus ein „visuelles Puppenspiel“ ins Leben gerufen, bei dem granulare Details von Bewegungsabläufen analysiert und dann möglichst authentisch auf einen anderen Körper übertragen werden. Die wiederum bekannteste und meistgenutzte Art von Deep Fakes sind sogenannte Face Swaps. Bei Face Swaps lernt der Algorithmus physische Merkmale von Gesichtern, um diese miteinander zu tauschen. Bei Videoinhalten werden dabei auch die gezeigte Mimik und deren Veränderung im Zeitablauf verinnerlicht.

Während sich die verschiedenen Deep Fake Varianten unterschiedlicher Medienformate bedienen und heutzutage in unterschiedlichem Maße realitätsgetreue Ergebnisse erzielen können, lässt sich die Produktion eines Deep Fakes grundsätzlich in die gleiche Schrittreihenfolge unterteilen. Zunächst werden relevante Merkmale des Quellmediums extrahiert, und der Algorithmus darauf trainiert. Dabei kann es sich um Gesichtsmerkmale, markante Bewegungen, oder die Stimmfarbe handeln, die sozusagen eine Schablone generieren, die im zweiten Schritt auf das Zielmedium projiziert wird.

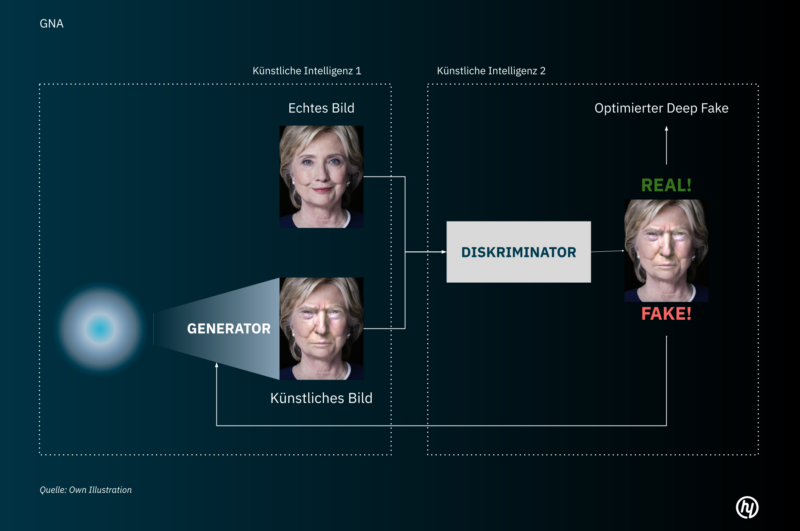

Das Analysieren, Extrahieren, und Projizieren findet auf technischer Ebene durch einen sogenannten Autoencoder oder zusätzlich durch ein Generative Adversarial Network (GAN) statt. Während der Autoencoder die genannten Schritte methodisch bearbeitet, treten bei einem GAN verschiedene neuronale Netzwerke gegeneinander an, um die Manipulation Stück für Stück zu optimieren. Für weitere Details rund um die Funktionsweise von Autoencodern und GANs zur Erstellung von Deep Fakes haben wir in einem kurzen Anhang einige ergänzende Erklärungen bereitgestellt.

Wie nutzen Unternehmen Deep Fake Technologie zur Wertschöpfung?

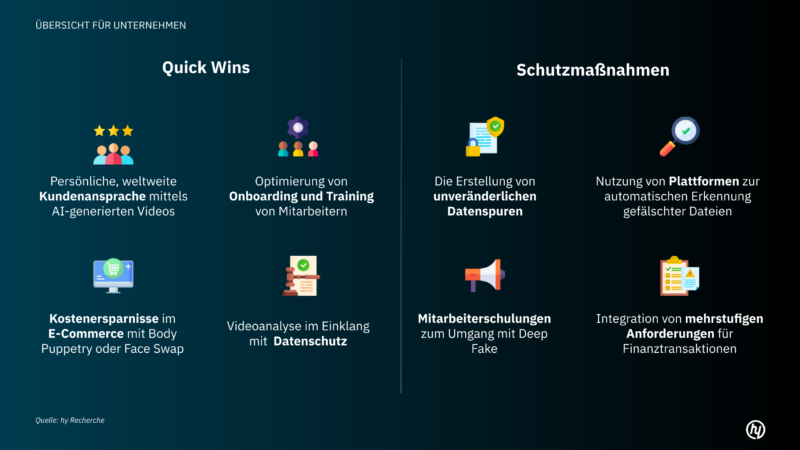

Deep Fake Anwendungen werden nicht zuletzt durch naheliegende Assoziationen mit Fälschungen und Täuschung häufig zu einem Werkzeug von Betrügern reduziert. Doch ähnlich wie bei anderen aufstrebenden Anwendungen von Technologie, beispielsweise der Kryptowährung als zentraler Anwendungsfall der Blockchain Technologie, haben auch im Bereich Deep Fakes Startups und etablierte Unternehmen längst damit begonnen, Anwendungsfälle zur nachhaltigen Wertschöpfung zu identifizieren und erfolgreiche Produkte darauf aufzubauen.

Statt des negativ konnotierten Begriffs „Deep Fake“ wird dabei meist von der Erstellung von „Synthetischen Medien und Objekten“ gesprochen, die beispielsweise zur Vereinfachung von Prozessen oder sogar als Sicherheitsanwendung dienen können. Im Folgenden wollen wir mehrere konkrete Anwendungsbeispiele kurz beleuchten.

Rephrase.AI: Personalisierung von Medieninhalten für effizientere Kundenansprache

Der Wettbewerb um Neukunden hat in vielen Branchen seinen absoluten Höhepunkt erreicht. Neben großzügigen Rabatten und attraktiven Lockangeboten sehen viele Unternehmen Personalisierung als entscheidenden Hebel um gezielter und nachhaltiger Kundenbeziehungen aufzubauen und sich von Wettbewerbern abzuheben. Hilfe dafür gibt es durch die Plattform vom indischen Startup Rephrase.AI, auf der Deep Learning Algorithmen personalisierte Videos für gezielte Vertriebs- und Marketinginitiativen produzieren. „Unser Ziel bei Rephrase.ai ist es, die Art und Weise, wie wir kommunizieren, neu zu gestalten, um unserer visuellen Kultur besser zu entsprechen“, sagt Ashray Malhotra, CEO von Rephrase.ai. Neben B2B-SaaS-Unternehmen und Marketingagenturen zählt das Startup bereits Amazon, PwC und Johnson&Johnson zu seinen Kunden.

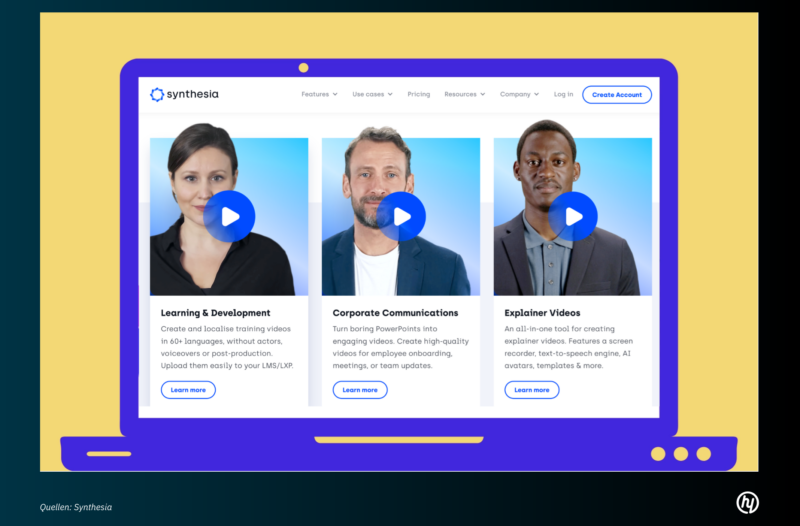

Synthesia: Synthetische Medien fürs Onboarding und Training von Mitarbeitern

Synthetische Produktion von Medieninhalten durch Algorithmen kann Unternehmen einen wesentlichen Kostenvorteil verschaffen. Das Londoner Startup Synthesia hat einen Algorithmus entwickelt, welcher Anleitungs- und Schulungsvideos für Kunden produziert und dabei eine Ersparnis von 90% in Zeit- und Kostenaufwand gegenüber traditioneller Produktion verspricht. In drei intuitiven Prozessschritten werden Avatare, Text, und Video erstellt, die bereits von Unternehmen wie Reuters, BBC oder Nike genutzt werden.

Data Grid und Pinscreen: Multiplikation von Medieninhalten durch synthetische Produktion

Wertschöpfende Anwendung von Deep Fakes heißt auch im E-Commerce-Bereich vor allem: Kostenersparnis bei Shootings und Werbedrehs bei nahezu gleichbleibender, visueller Qualität. Ein Beispiel hierfür ist Data Grid, ein ursprünglich auf dem Campus der Universität Kyoto ins Leben gerufenes Unternehmen, welches mit Hilfe von Body Puppetry E-Commerce Unternehmen eine beliebige Anzahl realistisch aussehender Menschen, sprich Fotomodelle, zur Verfügung stellen kann. Die synthetisch generierten Personen werden bereits bei vielen Mode-Händlern genutzt, beispielsweise um ständig neue Looks und Posen an sich wechselnden Personen zu präsentieren. Die Fähigkeit, eine authentische Person immer besser synthetisch abbilden zu können, entwickelt der Algorithmus durch die Anwendung von einem GAN, welches in unserem technischen Anhang näher erläutert wird.

Wem synthetische Gesichter nicht reichen, kann alternativ auch auf die Gesichter echter Personen zurückgreifen, um diese in Filmen oder Werbevideos zu integrieren ohne die notwendigen Aufnahmen tatsächlich machen zu müssen. Das US-Unternehmen Pinscreen verfügt über eine fortgeschrittene KI-Gesichtssynthesetechnologie, die zunächst bekannte Gesichter in ihren Algorithmus einpflegt, um diese dann wie eine Schablone beliebigen Personen realitätsnah einzusetzen. Im Gegensatz zu bestehender Deep-Fake-Software kann diese Lösung eine hochauflösende Ausgabe gewährleisten und eignet sich daher für High-End-VFX-Produktionen. Der deutsche Versandhändler Zalando hat Pinscreen bereits in der Vergangenheit genutzt, um 290.000 lokalisierte Anzeigen vom Model Cara Delevingne zu erstellen, in denen alternative Aufnahmen und Stimmen gezeigt werden. Auch hier wird zusätzlich versucht, die Inhalte zu personalisieren, indem jeweils die Stadt erwähnt wird, in der die Werbung gezeigt wird.

Brighter.AI: Täuschung als Mittel zum Datenschutz

Auch in Deutschland arbeiten Software-Entwickler daran, „Deep fakes for good“ zu entwickeln: Das Berliner Startup Brighter.ai (Brighter.ai) wirbt damit, jede Identität in der Öffentlichkeit zu schützen und löst somit das Problem um Datenschutzbestimmungen wie GDPR. Unternehmen wie die Deutsche Bahn, Renault oder Hella arbeiten mit Brighter.ai zusammen, um die Brücke zwischen Videoanalyse und Datenschutz in Deutschland zu schlagen. Die Technologie des Unternehmens kann Gesichter entweder präzise anonymisieren oder aber mithilfe eines Face Swaps die wahre Identität verschleiern und reduziert so die Risiken von Unternehmen, öffentliche Videodaten für Erhebungen zu sammeln.

Was sind relevante Risiken für Unternehmen?

Was auf geopolitischer Ebene zum Zweck der Desinformation und Täuschung genutzt werden kann, ist ebenso auf Unternehmensebene ein ernstzunehmender Risikofaktor. Spätestens seit der Veröffentlichung von Applikationen wie “FaceSwap” oder “Reface” ist jeder mit Internetzugang dazu fähig, synthetische Medien mittels Algorithmus mit wenig Aufwand zu erstellen, also einen Deep Fake zu produzieren. Während öffentliche Tools zumeist einen geringeren Grad an Realismus ermöglichen und (noch) leicht erkennbar sind, können professionalisierte Anwender auf verschiedensten Wegen risiken für Unternehmen darstellen.

Betrugsfälle durch Audio Deep Fakes

Das Forbes Magazine (Forbes) berichtete bereits 2019 von einem Deep Fake Betrug, bei dem ein britisches Unternehmen umgerechnet knapp 300k € verlor. Hierbei wurde mittels Deep Fake die Stimme eines deutschen Firmenchefs nachgeahmt. Nicht nur der Akzent, sondern auch die Melodie der Stimme konnten angabegemäß täuschend echt gefälscht werden. Die Aufforderung der synthetisch generierten Stimme, eine Überweisung an ein bisher fremdes Konto zu tätigen, wurde vom zuständigen Mitarbeiter nicht hinterfragt, der somit dem Betrüger willentlich das Geld direkt aufs Konto schickte. Mehrere weitere Betrugsfälle, bei denen Unternehmen mit Audio-Deep Fakes um bis zu siebenstellige Summen betrogen wurden, können auf den Einsatz von Deep Fakes zurückgeführt werden (Symantec).

Betrugsfälle durch synthetische E-Mails

Neben dem CEO-Betrug mittels synthetischer Stimmenfälschung kann mittlerweile sogar der Schreibstil und die Wortwahl einer Person nachgeahmt werden. Dafür braucht es lediglich einiges an Textmaterial dieser Person, sodass die Deep Learning Technologie angewandt werden kann. So können E-mails generiert werden, die im schlimmsten Fall dazu führen, dass Mitarbeiter sensible Daten und Passwörter ihres Unternehmens preisgeben. Da die Technologie inzwischen so einfach anzuwenden ist, sind nicht mehr nur Corporates von den Risiken betroffen, sondern auch kleine und mittelständische Unternehmen.

In Zukunft können auch Deep Fake Videos zur Gefahr für Unternehmen werden

Auch bei Deep Fake in Form eines Videos kann es zu folgenschweren Konsequenzen für Unternehmen kommen: Wird beispielsweise ein gefälschtes Video eines CEO veröffentlicht, der sich zu sensiblen Themen des Unternehmens äußert, kann es schnell zu einem Absturz der Aktienkurse kommen.

Hierbei sind die ersten 24 Stunden nach der Veröffentlichung von Fake News entscheidend, zeigen Studien (Prevency). Gerade bei Deep Fake Videos ist es extrem schwierig, die Öffentlichkeit von der Fälschung zu überzeugen und so das Unternehmen vor dem Verlust seiner Glaubwürdigkeit zu schützen. Hier gilt es in Zukunft, den richtigen Umgang mit Falschinformationen zu finden und für den Ernstfall gewappnet zu sein.

Was gibt es für Maßnahmen zum Schutz von Unternehmen?

„With great power comes great responsibility, and since we are driven by both technology and ethics, we have solid safeguards in place“ – Unternehmen wie Rephrase.ai, die mit Deep Learning Algorithmen arbeiten, Nachahmungen generieren und diese anbieten, sind sich ihrer Verantwortung bewusst und zeigen Möglichkeiten und Tools zur Deep Fake Erkennung auf.

OARO: Erstellung von unveränderlichen Datenspuren

Einige Startups haben die Deep Fake Gefahr für Unternehmen erkannt und widmen sich mit ihrem Produkt der Erkennung und Prävention von Falschinformationen im Internet. Das kanadische Unternehmen OARO (OARO – Unfakeable Records) bietet Lösungen, um die Identitäten, Zugangskontrolle und Authentifizierung von internen und externen Stakeholdern zu verwalten und das Unternehmen so vor digitalen Betrug zu schützen. Dafür entwickelte OARO eine App, die eine unveränderliche Datenspur mit Zeitstempel und GPS-Koordinaten generiert, die es ermöglicht, jedes Foto oder Video zu authentifizieren. Ähnliches bietet das Unternehmen sensity (Sensity – Visual Threat Intelligence Platform) an.

Sentinel und Quantum & Integrity: Plattformen für Echtheitsprüfung hochgeladener Dateien

Sentinel (Sentinel) stellt sich nach eigenen Angaben dem Informationskrieg und den Deep Fakes mittels einer KI-basierten Schutzplattform. Unternehmen können hier Inhalte hochladen, die dann automatisch auf KI-Fälschungen analysiert werden. So wird bestimmt, ob es sich um ein Deep Fake handelt und eine Visualisierung der Eingriffe wird gezeigt. Das von der EU unterstützte Unternehmen Quantum & Integrity (Quantum Integrity – AI-Powered Deep Fake Detection) bietet ein umfassendes Angebot an Detektionsmechanismen. Erkannt werden können Computerbildschirmfotos, die als Original ausgegeben werden, veränderte Dokumente sowie Deep Fake von Live-Videoanrufen.

Group Cyber ID (GCID): Forensische Beschaffung, Analyse und Bewertung von gefälschten Dateien

Neben der automatischen Erkennung gibt es auch Möglichkeiten, sich mittels forensischer Verfahren als Unternehmen zu schützen: Die GCID kann Tonaufnahmen und Videomaterial analysieren und bewerten, die vor Gericht als zulässige Beweismittel verwendet werden können.

Reuters und Facebook: Umfassende Aufklärung der Mitarbeiter

Die Aufklärung von Mitarbeitern und Kunden durch umfassende Schulungen ist ein einfacher erster Schritt, der Gefahr durch Deep Fake entgegenzuwirken. Die Nachrichtenagentur Reuters bietet, gesponsert von Facebook, einen kostenlosen Online-Kurs in 16 verschiedenen Sprachen an. Unter dem Titel „Identifizierung und Auseinandersetzung mit manipulierten Medien“ wird in drei Kapiteln unterrichtet und auf den Umgang mit Deep Fake vorbereitet.

In a nutshell: Hintergrund und Relevanz von Deep Fakes für Unternehmen

Je größer die Detailtiefe, die ein Deep Learning Algorithmus erfassen kann, desto höher der Realitätsgrad des Deep Fake. Das neuronale Netz umfasst eine Struktur, die in ihrer Granularität für das menschliche Auge nicht erkennbar ist. Tausende, sich dynamisch verändernde Pixel für den Algorithmus sind visuell für uns nur als das einfache Heben einer Augenbraue erkennbar. Die analysierten Merkmale sind für den Algorithmus eine riesige Sammlung an Anweisungen und Formeln, die auf das Zielmedium angewandt werden können, um es in der Struktur an das Original anzugleichen. Und fertig ist die Fälschung, erstellt von einem sehr gründlichen Fälscher mit enormer Rechenpower.

Deep Fakes und deren Auswirkungen zeigen, wie entscheidend eine frühzeitige Auseinandersetzung mit einer sich dynamisch entwickelnden Technologie, und den damit verbundenen, gleichermaßen faszinierenden wie besorgniserregenden Möglichkeiten, ist. Durch die Einbindung von GANs wird der Realitätsgrad von Deep Fakes in jeglicher Form, sei es in visueller, auditiver, oder schriftlicher Form, in beschleunigter Form ansteigen. Tools um sich vor Betrug zu schützen und das Potenzial zu nutzen gibt es flächendeckend, letztendlich bleibt aber ein gesteigertes Bewusstsein sowie Wissen über Deep Fakes die wirksamste Maßnahme.

Exkurs

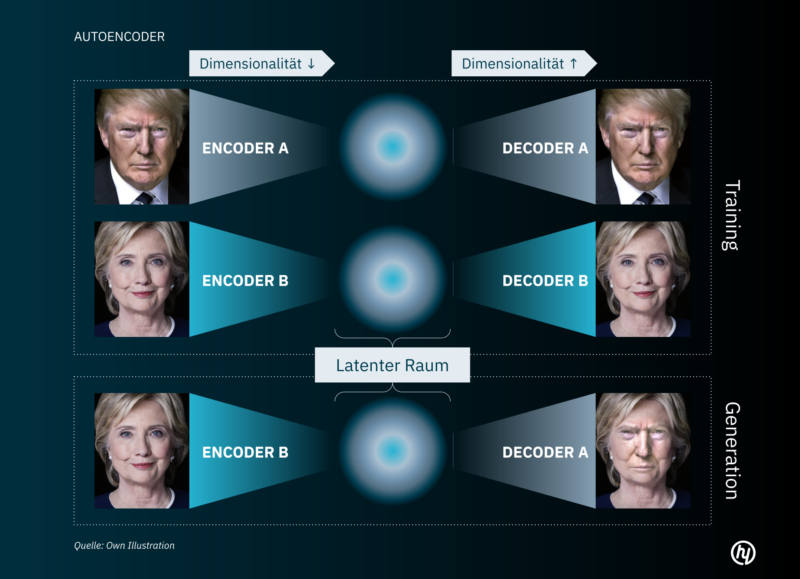

Wie entsteht ein Face Swap?

Die Produktion eines Deep Fake Face Swaps findet in üblicherweise in einem sogenannten Autoencoder in einem zweistufigen Prozess statt. Ein Autoencoder ist ein Deep Learning Algorithmus, der eine komprimierte Repräsentation von gegebenen Inhalten (beispielsweise die Reduzierung eines Gesichts auf die “wesentlichsten” Merkmale) erlernt und dann auf ein Zielmedium projizieren kann. Der wesentliche Prozess wird dabei in Encoder und Decoder untergliedert.

Der Encoder extrahiert das eingegebene Quellbild und formt damit eine Art Schablone für das Gesicht, welches sich dann im sogenannten latenten Raum befindet. Ein latenter Raum hat, im Gegensatz zu dem menschlich sichtbaren 3 dimensionalen Raum, n-Dimensionen. Es beschreibt also einen Raum, dessen dimensionale Größe nicht direkt messbar oder zugänglich ist, sondern innerhalb des jeweiligen Encoders bestimmt wird. Auf der anderen Seite des latenten Raums steht der Decoder. Die Aufgabe des Decoders ist es, eine latente Gesichtsschablone als Input zu bekommen und ein zuvor eingelerntes Gesicht in diese Schablone rein zu projizieren.

Während der Encoder also die Dimensionalität der Eingabedaten reduziert, projiziert der Decoder Stichproben aus der niedrigen Dimensionalität zurück in die höhere Dimensionalität.

Lässt man nun den Encoder ein bestimmtes Gesicht in den latenten Raum codieren und gibt man dem Decoder ein ganz anderes Gesicht als Zielbild, so wird der Decoder das Gesicht aus dem latenten Raum vom Encoder in das gewünschte Ziel-Gesicht projizieren.

Möchte man diesen Prozess optimieren, spricht man von einer anderen Technologie namens Generative Adversarial Networks bei der ein zweites neuronales Netz verwendet wird, um den zuvor generierten Deep Fake zu überprüfen und zu optimieren.

GANs zu trainieren ist ein unglaublich zeitaufwendiger Prozess und benötigt ein Vielfaches an Rechenpower, weshalb im Netz noch nicht viele GNA Deep Fakes zu sehen sind.