Startups finden mit BERT

Wie wir Natural Language Processing einsetzen, um neue Unternehmen zu identifizieren.

Ein wichtiger Bestandteil unserer Arbeit bei hy ist die systematische Analyse von Startup-Gründungen und Venture Capital-Investments. Neben der umfangreichen Untersuchung von Sektoren spielen auch die Analyse von Wettbewerbsfelder und die Identifizierung neuer Partner- oder Investmentmöglichkeiten zentrale Rollen.

Semantische Suche anhand von Beispielunternehmen

Bei der Durchführung von Kundenprojekten setzen wir zusätzlich zu proprietären Unternehmensdatenbanken unsere selbst entwickelte Scouting-Technologie ein. In der internen Datenbank werden u.a. Volltext-Daten wie Unternehmensbeschreibungen, Webseiten- und News-Texte gespeichert, indiziert und analysiert. Aufbauend auf klassischen Suchtechnologien, wie ElasticSearch und Query Expansion, erproben wir neue Technologien, um immer bessere Ergebnisse in unseren Scouting-Prozessen zu erzielen. Zuletzt haben wir auf der Basis von BERT(Bidirectional Encoder Representations from Transformers) eine neue Software entwickelt, die uns hilft eine Vielzahl ähnlicher Startups anhand von nur wenigen Referenzunternehmen aufzufinden.

Similarity-Suche mit BERT: Das Tool findet effizient Unternehmen die ähnlich zu vorgegeben Beispielunternehmen sind.

Die Technologie: Grundlagen von BERT

BERT setzt mehrere Techniken um, die es uns helfen ein leistungsfähiges Verfahren zur Startup-Ähnlichkeitsanalyse zu implementieren. Zum einen verarbeitet das Modell die Sprache im Kontext und erkennt somit die unterschiedliche Bedeutung von Wörtern abhängig von ihrer Verwendung. Das Modell kann beispielsweise erkennen, dass mit dem Wort “Bank” in den Unternehmensbeschreibungen “Hersteller von Bank- und Stuhlschrauben” und “Bank und Finanzdienstleister” jeweils etwas anderes ausgedrückt wird. Das Modell erlernt auch, welche Arten von Wörter wichtig für die Bestimmung von Ähnlichkeiten sind und welche eine weniger entscheidende Rolle spielen.

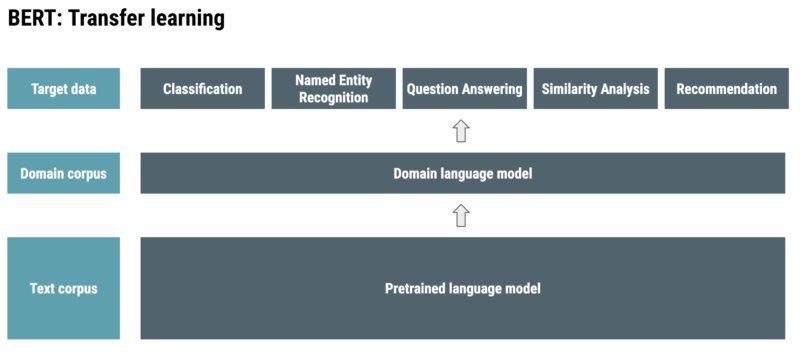

Desweiteren ermöglicht BERT eine neue Trainingsmethode, das sogenannte Transfer Learning. Diese Methode wird schon seit einigen Jahren erfolgreich in der Computer Vision benutzt und hat diesem Bereich zu einem großen Sprung nach vorne verholfen. Es wurde intensiv nach Möglichkeiten erforscht das Transfer Learning auch für die Sprachverarbeitung effektiv nutzbar zu machen, bis im Jahr 2018 endlich der Durchbruch gelang. Ein Modell wird hierbei auf eine sehr große Menge von Volltextdaten, wie News- oder Wikipedia-Artikel, trainiert und erlernt hierbei zunächst viele Facetten zum grundsätzlichen Aufbau der Sprache. Dieses kann als Basis benutzt werden, um effizienter zusätzliche Daten der Zieldomäne mit einzubeziehen. Zuletzt wird das Modell zur Lösung des eigentlichen Zielproblems, wie etwa für die Textklassifizierung oder Ähnlichkeitsanalyse, trainiert. Dieses stufenweise trainieren von Modellen ermöglicht es, große vor-trainierte Modelle wiederzuverwenden um schließlich mit relativ wenig annotierten Daten das Zielproblem präzise zu lösen.

Transfer learning

Seit der Veröffentlichung von BERT im November 2018 ist viel passiert. Google und Microsoftsetzen die Technologie bereits im Produktivbetrieb ein. In der Forschungs-Community überschlagen sich unterdessen die Meldungen zu immer weiter verbesserten Modellen. Viele AI-Forschungsgruppen großer Technologiekonzerne (u.a. Facebook, Salesforce) und Universitäten arbeiten aktuell daran die Basis-Architektur weiterzuentwickeln oder für bestimmte Anwendungsfälle zu optimieren. Die neuen Forschungsvorhaben zielen z.B. darauf ab die Modelle leichtgewichtiger und schneller zu machen oder für eine spezifische Domäneanzupassen.

“In light of the impressive empirical results of ELMo, ULMFiT, and OpenAI it only seems to be a question of time until pretrained word embeddings will be dethroned and replaced by pretrained language models in the toolbox of every NLP practitioner. This will likely open many new applications for NLP in settings with limited amounts of labeled data. The king is dead, long live the king!”

Integration in den Ecosystem Manager

Aufgrund unserer umfangreichen Projekthistorie können wir auf eine große Menge von händisch kuratierten und klassifizierten Unternehmensdaten zurückgreifen. Diese dienen zum einen als Trainingsdaten, anhand deren das Modell lernen kann, welche Art von Sprachkonstrukte generell wichtig für die Ähnlichkeitsanalyse sind. Zum anderen können wir einen bestimmten Teil der Daten als Evaluationsdaten verwenden und prüfen, wie gut unsere neue Entwicklung im Vergleich zu vorherigen Ansätzen abschneidet. Mit Hilfe dieser Daten und dem BERT-Basismodell, haben wir eine Ähnlichkeitsanalyse implementiert und können genau den Grad der Ähnlichkeit von zuvor nicht gesehen Unternehmen voraussagen und verfügen über ein leistungsstarkes Tool, das uns beim Scouting nach neuen Startups effizient unterstützt.

Aktuell integrieren wir diese Technologie in den Ecosystem Manager und machen hiermit diesen neuen Ansatz für unsere Kunden zugänglich. Wenn Sie Interesse an der Technologie haben und eine Produktdemo wünschen, dann senden Sie uns einfach eine kurze Nachricht.